Het definitieve ontwerp van de EU-wet op de kunstmatige intelligentie (1, 2) (AI-wet) werd op 14 juni met een meerderheid van stemmen goedgekeurd door het EU-parlement. Met deze stemming gaat de AI-wet nu de laatste fase van het wetgevingsproces in. Het is een baanbrekend stuk wetgeving dat uitgaat van een op risicogebaseerde benadering van de regulering van AI-systemen (3), waarbij bepaalde toepassingen worden verboden en andere aan strenge regelgevings- en nalevingsverplichtingen worden onderworpen. Om een paar voorbeelden van AI-systemen te noemen, denk aan gezichtsherkenningssoftware, automatiseringssoftware, aanbevelingssystemen en zelfs in zeer brede zin, datagedreven systemen die je helpen je activiteiten te optimaliseren en betere beslissingen te nemen op basis van de doelstellingen van je organisatie.

In onze hoedanigheid van aanbieder van AI-oplossingen hebben we bij Eraneos de ontwikkelingen rond deze aanstaande wetgevingswet, de risicogebaseerde benadering ervan en de gevolgen voor ons werk en onze klanten nauwlettend gevolgd.

Een bijzonder belangrijke ontwikkeling met betrekking tot deze stemming is dat de AI-wet nu is herzien om zogenaamde foundation- en generatieve modellen te behandelen als hun eigen speciale categorie met specifieke verplichtingen voor aanbieders van dergelijke AI-modellen.

AI-wet in een notendop

Als reactie op de snelle ontwikkelingen op het gebied van technologie en AI heeft de EU de AI-wet voorgesteld als een regelgevingskader dat ervoor moet zorgen dat AI-systemen die in de EU worden geplaatst en gebruikt veilig zijn en de bestaande wetten, de grondrechten van de burgers en de waarden van de vakbonden respecteren.

Samengevat hanteert de goedgekeurde AI-wet een risicogebaseerde benadering van AI-toepassingen, waarbij deze worden gerangschikt van onaanvaardbaar, hoog risico, beperkt risico tot toepassingen met een laag risico en waarbij speciale aandacht wordt besteed aan zogenaamde generatieve AI-systemen.

Onaanvaardbare toepassingen – systemen zoals realtime gezichtsherkenning, sociale scoresystemen (gebaseerd op gedrag of sociaaleconomische status van mensen), voorspellend politiewerk, evenals software voor emotieherkenning voor bijvoorbeeld rechtshandhaving. Deze worden allemaal terecht beschouwd als een bedreiging voor mensen en zeer in strijd met hun grondrechten en mogen daarom niet op de markt worden gebracht binnen de EU.

Systemen met een hoog risico – systemen die de veiligheid van mensen of hun rechten negatief kunnen beïnvloeden – moeten worden beoordeeld voordat ze op de markt worden gebracht en moeten gedurende hun hele levenscyclus opnieuw worden beoordeeld. Deze worden onderverdeeld in twee grote categorieën:

1. AI-systemen die in 8 specifieke toepassingsgebieden vallen:

- Biometrische identificatie en categorisatie van natuurlijke personen

- Beheer en werking van kritieke infrastructuur

- Onderwijs en beroepsopleiding

- Werkgelegenheid, werknemersbeheer en toegang tot zelfstandig ondernemerschap

- Toegang tot en genot van essentiële particuliere diensten en openbare diensten en voordelen

- Rechtshandhaving Beheer van migratie, asiel en grenscontrole Hulp bij juridische interpretatie en toepassing van de wet

2. AI-systemen die worden gebruikt in producten zoals speelgoed, auto’s, medische apparatuur die andere veiligheidsbeoordelingen moeten ondergaan volgens de EU-regels en voorschriften voor productveiligheid.

Voorbeelden hiervan zijn zoek- en matchalgoritmen in werving, of dingen zoals AI-systemen die bedoeld zijn om te worden gebruikt als veiligheidscomponenten in de werking van wegen en het beheer van het verkeer, of de levering van water, gas, verwarming en elektriciteit om er maar een paar te noemen.

Tot slot omvatten systemen met een beperkt risico en een laag risico toepassingen zoals AI-geschikte video- en computerspellen, spamfilters en de meeste andere soorten AI-systemen.

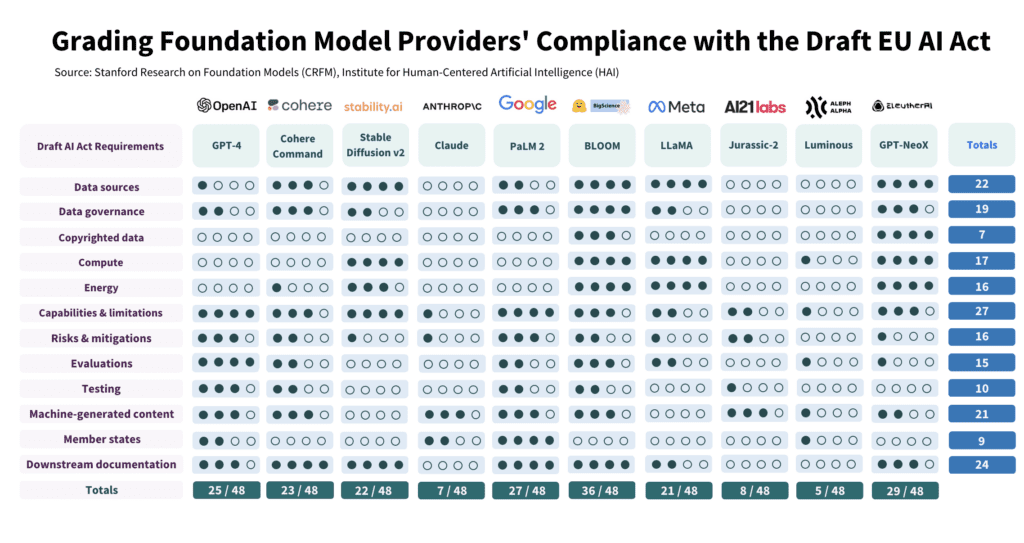

Figuur 1 – AI-Act nalevingsbeoordelingen van vlaggenschip foundation modellen van verschillende aanbieders (4)

Wat betekent de door het Europees Parlement goedgekeurde AI-wet voor foundation modellen? Kort gezegd betekenen de goedgekeurde wijzigingen dat modellen zoals GPT4, die ten grondslag liggen aan de toegenomen belangstelling voor toepassingen zoals ChatGPT, nu worden beschouwd als modellen met een hoog risico onder de AI-wet. Dit betekent dat hun aanbieders,

“…. mogelijke risico’s (voor gezondheid, veiligheid, grondrechten, milieu, democratie en rechtsstaat) moeten beoordelen en beperken en hun modellen in de EU-databank moeten registreren voordat ze op de EU-markt worden gebracht.” (5)

Aanbieders van generatieve AI-toepassingen die bovenop foundationmodellen zijn gebouwd (bijvoorbeeld Open-AI’s ChatGPT dat bovenop GPT3.5 en GPT4 is gebouwd) zijn nu ook verplicht om duidelijk onderscheid te maken tussen AI-gegenereerde inhoud en om de gegevensbronnen te beschrijven die zijn gebruikt om de modellen te trainen, om ervoor te zorgen dat de auteursrechtwetgeving wordt nageleefd. (6, 7)

Op dit moment wordt er door een groot aantal organisaties gewerkt aan de beoordeling van de verschillende mate van naleving van de AI-wet, maar het is al duidelijk dat bepaalde aanbieders in dit opzicht sprongen vooruit zijn.

Recent werk van onderzoekers van Stanford’s Human-Centered Artificial Intelligence Lab bijvoorbeeld, scoort BLOOM (en zijn provider HuggingFace) als de meest conforme entiteit met betrekking tot 12 geanalyseerde categorieën van AI-Act vereisten. Figuur-1, die hun bevindingen samenvat, laat zien hoe ver BLOOM in dit opzicht voorop loopt.

Tegelijkertijd scoren veel aanbieders slecht op het gebied van risicobeperking en het openbaar maken van risico’s. Met een hoog potentieel voor misbruik en oneigenlijk gebruik, maken relatief weinig aanbieders bekend welke risicobeperkende maatregelen ze hebben genomen, of hoe effectief deze zijn, als het gaat om zorgen over de veiligheid van foundationmodellen en producten/oplossingen die van dergelijke modellen zijn afgeleid. Zoals de onderzoekers het stellen, meten de leveranciers zelden de prestaties van hun model in geval van opzettelijk misbruik. Dit heeft zeer belangrijke gevolgen voor de bezorgdheid over cyberveiligheid met betrekking tot foundation-modellen en generatieve AI-toepassingen en laat zien dat de sector nog meer tijd nodig heeft om volwassen te worden.

Wat dit betekent voor Eraneos en onze klanten

Wat zijn de gevolgen voor Eraneos en onze klanten? Het antwoord hangt natuurlijk sterk af van de specifieke sectoren, toepassingen en/of oplossingen waar we aan werken. Maar wat zeker duidelijk is, is dat AI-systemen niet overal kunnen worden aangepast en ingezet en dat we ze moeten bekijken vanuit het perspectief van risicomanagement. Met andere woorden, we moeten goed nadenken over onze verplichtingen, vooral als we oplossingen of toepassingen willen bouwen bovenop AI-systemen met een hoog risico, zoals foundation modellen.

Daarnaast zijn er ook kosten voor naleving die moeten worden overwogen. Effectbeoordelingsstudies van de EU-Commissie zelf (8) schatten de nalevingskosten op ruwweg 10-14% van de totale ontwikkelingskosten. Bovendien:

“… schat de Europese Commissie de nalevingskosten voor één AI-project in het kader van de AI-wet op ongeveer 10.000 euro en concludeert dat bedrijven in eerste instantie totale kosten van ongeveer 30.000 euro kunnen verwachten. Naarmate bedrijven professionele benaderingen ontwikkelen en als business as usual worden beschouwd, verwacht zij dat de kosten dichter bij de 20.000 euro zullen liggen.” (9)

Binnen de EU zelf bestaat er bezorgdheid over onevenredig hoge nalevingskosten en aansprakelijkheidsrisico’s (10) voor bedrijven die werken met generatieve AI-modellen en deze ontwikkelen.

Toch moeten we ons ook bewust zijn van de onvolwassenheid van de markt als het gaat om het begrijpen en beperken van de risico’s en mogelijke schade van foundation en generatieve modellen. Het beveiligen van generatieve AI-oplossingen is zeker een van de grootste uitdagingen, aangezien beveiligingsonderzoekers herhaaldelijk hebben aangetoond hoe gemakkelijk de vangrails rond de onderliggende modellen kunnen worden omzeild door middel van zogenaamde “prompt-injection” bijvoorbeeld. (11)

Er wordt momenteel hard gewerkt aan het definiëren, standaardiseren, meten en benchmarken van AI-systemen met betrekking tot cyberbeveiliging door de academische gemeenschap, maar ook door bestuursorganen zoals ENISA (12) en standaardiseringsorganen zoals het Amerikaanse National Institute of Standards and Technology (NIST) om kaders op te stellen voor een betere beveiliging van AI-systemen en het omgaan met de risico’s ervan (13). Deze positieve stappen hebben nog tijd nodig om vruchten af te werpen.

AI is geen toverstafje en hoewel het enorme waarde kan opleveren voor zowel publieke als private organisaties, moet het idealiter worden toegepast door professionals die rekening houden met de verschillende risico’s en gevolgen van AI en er voor zorgen dat wordt voldaan aan ethische en wettelijke verplichtingen.

Onze ervaring in het leveren van complexe data- en AI-oplossingen en ons begrip van de complexiteit van dit landschap zorgen ervoor dat we organisaties goed kunnen adviseren over hoe ze moeten navigeren door de implicaties van de op risico gebaseerde AI-ontwikkelingsbenadering. Hoe ze AI in de praktijk kunnen toepassen, hoe ze valkuilen kunnen vermijden en de risico’s kunnen beperken. Als je jezelf afvraagt wat de AI-wet voor jouw organisatie kan betekenen of als je hulp nodig hebt bij het navigeren door dit landschap, neem dan contact op met ons of met een van onze experts.

Bij Eraneos combineren we zakelijk inzicht, technische kennis, uitgebreide ervaring en onze innovatieve mindset om je data te activeren en om te zetten in daadwerkelijke waarde. We worden gedreven door het behalen van zinvolle resultaten en zijn toegewijd aan optimaal benutten van het volledige potentieel van digitalisering en Data & AI specifiek. We adviseren over, ontwerpen, bouwen en leveren Data & AI-oplossingen.

Bronnen

- The AI Act (https://eur-lex.europa.eu/legal-content/EN/TXT/?uri=celex%3A52021PC0206)

- Annexes to the AI-Act (https://eur-lex.europa.eu/resource.html?uri=cellar:e0649735-a372-11eb-9585-01aa75ed71a1.0001.02/DOC_2&format=PDF)

- The exact definition of what constitutes an AI System is still being debated and finalized through the trilogue negotiations process of the EU. The AI-Act broadly refers to “software that is developed with one or more of the techniques and can, for a given set of human-defined objectives, generate outputs such as content, predictions, recommendations, or decisions influencing the environments they interact with” as AI systems.

- Rishi Bommasani and Kevin Klyman and Daniel Zhang and Percy Liang, “Do Foundation Model Providers Comply with the Draft EU AI Act?” (https://crfm.stanford.edu/2023/06/15/eu-ai-act.html)

- “MEPs ready to negotiate first-ever rules for safe and transparent AI”, European Parlimiament Press Release (https://www.europarl.europa.eu/news/en/press-room/20230609IPR96212/meps-ready-to-negotiate-first-ever-rules-for-safe-and-transparent-ai)

- Lois Beckett and Kari Paul, “‘Bargaining for our very existence’: why the battle over AI is being fought in Hollywood”. The Guadrian, July 22 2023. (https://www.theguardian.com/technology/2023/jul/22/sag-aftra-wga-strike-artificial-intelligence)

- Emma Roth, “Hollywood’s writers and actors are on strike”. The Verge, Jul 25, 2023. (https://www.theverge.com/2023/7/17/23798246/strike-hollywoods-writers-actors-wga-sag-aftra)

- Renda, Andrea et al. “Study to support an impact assessment of regulatory requirements for Artificial Intelligence in Europe”. 2021. DOI: 10.2759/523404 (https://op.europa.eu/en/publication-detail/-/publication/55538b70-a638-11eb-9585-01aa75ed71a1)

- Khari Johnson, “The Fight to Define When AI Is ‘High Risk’”. Wired 1 Sep 2021. (https://www.wired.com/story/fight-to-define-when-ai-is-high-risk/)

- JAvier Espinoza, “European companies sound alarm over draft AI law”. Financial Times, June 30 2023. (https://www.ft.com/content/9b72a5f4-a6d8-41aa-95b8-c75f0bc92465)

- Kai Greshake, “Indirect Prompt Injection Threats”. (https://greshake.github.io/)

- European Union Agency for Cybersecurity (ENISA). Multi-Layer AI Security Framework for Good Cybersecurity Pracitces for AI. June 07 2023. (https://www.enisa.europa.eu/publications/multilayer-framework-for-good-cybersecurity-practices-for-ai)

- National Insistitue for Standards (NIST), “AI Risk Management Framework” (https://airc.nist.gov/AI_RMF_Knowledge_Base/AI_RMF)